前言

如果你想深入了解大数据处理技术,那么必不可少的就是学习Spark的工作原理。Spark是目前最流行的大数据处理框架之一,可以在分布式环境下快速处理海量数据。但是,它的工作原理却很多人不太清楚。

那么,Spark工作原理到底是什么呢?

今天,我将带着大家熟悉一下Spark任务提交执行的工作原理:

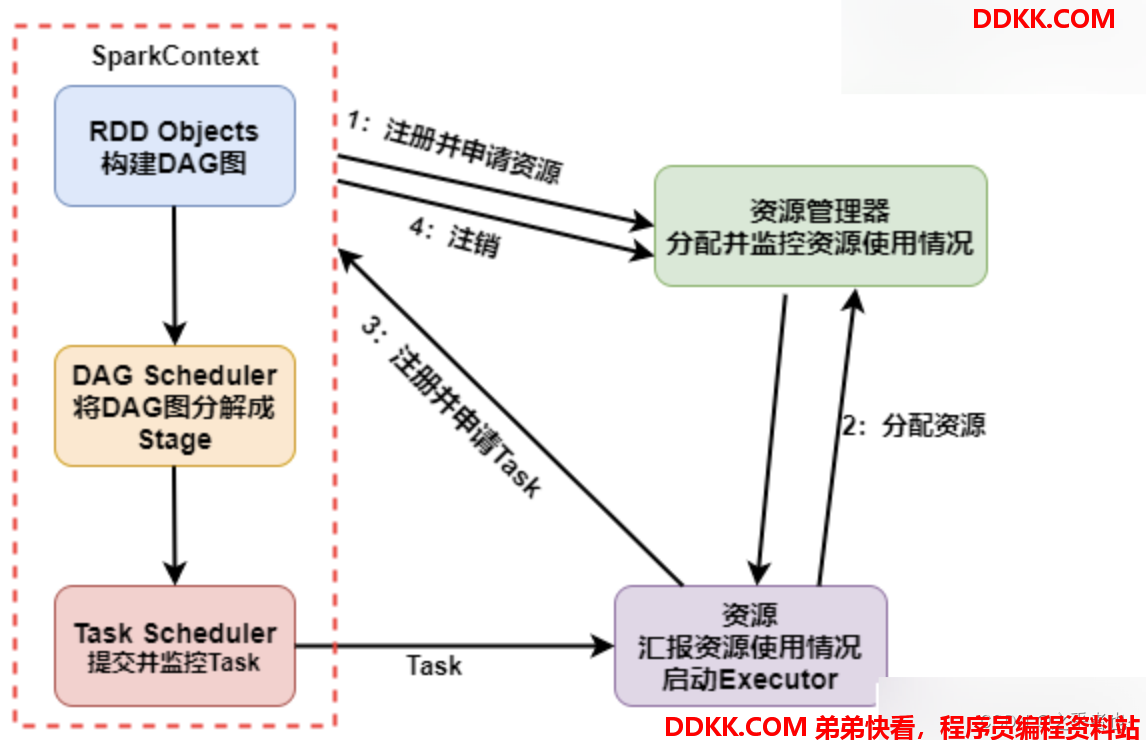

Spark的Application工作原理

可以概括为以下步骤:

1、 启动自己的程序Application:用户编写Spark应用程序,并启动该应用程序;

2、 使用spark-submit提交任务:使用spark-submit命令将应用程序提交给Spark这会触发Spark的Driver进程的启动;

3、 Driver进程执行Application:Driver进程是应用程序的主节点,负责协调任务的执行在Driver进程启动后,会进行一系列的初始化操作;

4、 SparkContext初始化:SparkContext是Spark应用程序与集群的连接点,负责资源的申请、任务的分配和监控在初始化过程中,SparkContext会构造出两个重要的实例:DAGScheduler和TaskScheduler;

5、 TaskScheduler连接Master:TaskScheduler是负责任务调度的组件,通过后台进程与Master节点建立连接;

6、 Master节点启动Executor:Master节点收到Application注册请求后,会使用自己的资源分配算法,在Spark集群的Worker节点上启动相应数量的Executor;

7、 Worker节点启动Executor:Worker节点为Application启动Executor进程,每个Executor都运行在独立的JVM中;

8、 Executor反向注册到Driver:Executor启动后,会向TaskScheduler进行反向注册,告知Driver自己可供任务执行;

9、 SparkContext完成初始化:所有Executor都反向注册到Driver上后,SparkContext完成初始化过程;

10、 编写程序逻辑:在SparkContext初始化完成后,用户可以编写自己的程序逻辑,定义数据处理操作;

11、 触发DAG执行:当用户调用Action操作时,会触发DAG(有向无环图)的构建每个DAG对应一个job;

12、 DAGSchedule划分Stage:DAGScheduler将DAG划分为多个Stage,每个Stage包含一组相互依赖的任务;

13、 TaskSchedule提交任务:TaskScheduler将每个Stage中的任务(TaskSet)提交给可用的Executor进行执行任务的分配由TaskScheduler根据具体算法进行决策;

14、 Executor执行任务:Executor内部有一个线程池,每当收到一个任务时,会使用TaskRunner封装任务并从线程池中取出一个线程来执行任务;

15、 任务执行完成:TaskRunner将编写的代码、要执行的算子或函数进行拷贝和反序列化,并在Executor上执行任务任务运行完毕后,将执行结果反馈给TaskScheduler,然后反馈给DAGScheduler同时,任务会将结果写入数据存储,并释放所有资源;

通过以上这些步骤,Spark的Application能够在分布式环境下高效地处理大规模数据。这种基于DAG的任务调度和Executor的并行执行机制,使得Spark具备了良好的容错性和可伸缩性,能够处理复杂的大数据处理任务。

Driver进程执行Application的过程

1.1 解析命令行参数

Driver进程会解析通过命令行传入的参数,包括应用程序的主类、资源配置、运行模式等信息。

1.2 创建SparkContext

SparkContext是Spark应用程序与集群的连接点,负责资源的申请、任务的分配和监控。在Driver进程启动后,会创建一个SparkContext实例。SparkContext初始化时,会根据传入的参数来配置集群环境、调度器等。

1.3 初始化日志记录

Driver进程会初始化日志记录相关的设置,包括日志级别、输出格式等。

1.4 设置Spark UI

Spark提供了一个Web界面,用于监控和调试应用程序。Driver进程会设置并启动Spark UI,使用户可以通过浏览器访问。

1.5 提交TaskSchedulerBackend

TaskSchedulerBackend是负责与集群资源管理器(如Mesos、YARN)通信的组件。Driver进程会提交TaskSchedulerBackend,以便与资源管理器建立连接。

1.6 启动DAGScheduler和TaskScheduler

DAGScheduler是负责将用户编写的代码转化为DAG(有向无环图)表示,并将其划分为一系列的Stage。同时,TaskScheduler负责任务的调度和分发。Driver进程会启动DAGScheduler和TaskScheduler实例,并与之建立通信。

1.7 等待任务执行完成

一旦初始化完成,Driver进程会等待任务执行完成。它会周期性地接收来自Executor的任务执行情况反馈,同时更新应用程序的状态和进度。

总之,Driver进程在启动后会进行一系列的初始化操作,包括创建SparkContext、设置日志记录、启动Spark UI、提交TaskSchedulerBackend等。这些初始化操作为应用程序的执行提供了必要的基础设施。

SparkContext初始化的过程

2.1 初始化和检查配置参数

SparkContext初始化时,会读取用户在命令行或配置文件中设置的参数,并进行一些基本的检查(比如检查必须的参数是否已经设置)。

2.2 创建和初始化SparkEnv

SparkContext会根据参数创建一个SparkEnv实例,其中包含了Spark应用程序执行所需的所有环境和组件,例如BlockManager、BroadcastManager、Serializer等。

2.3 创建和初始化SparkUI

SparkContext会启动并绑定一个Web服务器,以提供Spark UI。Spark UI是一个Web界面,用于监控和调试应用程序。

2.4 创建和初始化DAGScheduler

DAGScheduler是Spark应用程序的任务调度器,将用户代码转化为有向无环图(DAG)表示,并将其划分为一系列的Stage。SparkContext会创建并初始化一个DAGScheduler实例,并与之建立通信。

2.5 创建和初始化TaskScheduler

TaskScheduler是负责任务的调度和分发。SparkContext会创建并初始化一个TaskScheduler实例,并与之建立通信。

2.6 注册RDD和广播变量

一个Spark应用程序的主要数据结构是RDD和广播变量。在SparkContext初始化过程中,会注册应用程序中使用的所有RDD和广播变量,以便在后续的任务执行中进行管理。

2.7 创建和初始化BlockManagerMaster和BlockManagerSlave

BlockManager是Spark应用程序的内存管理器,负责缓存和管理数据块。SparkContext会创建并初始化一个BlockManagerMaster实例(用于跟踪所有BlockManager的状态),以及多个BlockManagerSlave实例(用于管理不同的Executor)。

2.8 启动和等待Executor

最后,SparkContext会启动所有的Executor,并等待所有任务完成后结束应用程序的执行。

总之,在SparkContext初始化过程中,会构造出两个重要的实例:DAGScheduler和TaskScheduler。这两个实例负责Spark应用程序的任务调度和分发,是Spark应用程序执行所必需的关键组件。

TaskScheduler连接Master的过程

3.1 创建TaskSchedulerDriver

TaskSchedulerDriver是TaskScheduler与Master节点进行通信的驱动程序。TaskScheduler会创建一个TaskSchedulerDriver实例,并使用Master节点的URL和调度模式进行初始化。

3.2 启动TaskSchedulerDriver

TaskSchedulerDriver启动后,会向Master节点发送注册请求,并等待Master节点的响应。一旦注册成功,TaskSchedulerDriver就可以查询集群状态和资源信息。

3.3 获取集群资源信息

TaskSchedulerDriver可以向Master节点查询集群的资源信息,例如可用的CPU、内存和磁盘容量等。这些信息对于任务调度和分配非常重要,因为它们可以帮助TaskScheduler确定任务执行的位置和资源需求。

3.4 分配任务给Executor

一旦TaskScheduler确定了任务的执行位置和资源需求,它就可以将任务分配给相应的Executor节点。TaskScheduler会向TaskSchedulerDriver发送任务分配请求,TaskSchedulerDriver再将其转发给Master节点。

3.5 监控任务执行

TaskScheduler会定期向Executor节点发送心跳消息,以监控任务的执行情况。如果任务执行失败或出现异常,TaskScheduler会将其重试或重新分配给其他Executor。

总之,TaskScheduler通过后台进程与Master节点建立连接,并使用TaskSchedulerDriver进行通信。TaskScheduler需要获取集群状态和资源信息,以便进行任务调度和分配。同时,它还需要监控任务的执行情况,以确保任务能够成功完成。

Master节点启动Executor的过程

4.1 接收应用程序注册请求

当Spark应用程序向Master节点发送注册请求时,Master节点会接收并处理该请求。注册请求包含了应用程序的相关信息,例如应用程序的名称、执行代码的位置等。

4.2 分配资源给应用程序

Master节点会根据资源管理策略和算法,为应用程序分配资源。资源可以包括CPU核数、内存容量、磁盘空间等。具体的资源分配算法可能会考虑当前集群的负载情况、各个Worker节点的可用资源以及应用程序的需求等因素。

4.3 启动Executor

一旦资源分配完毕,Master节点会向相应的Worker节点发送启动Executor的指令。Worker节点收到指令后,会启动Executor进程,并为其分配所需的资源。

4.4 Executor与Driver建立连接

Executor启动后,会与SparkContext中的Driver节点建立连接。这样,Driver节点就可以将任务分配给Executor执行,并通过网络传输数据和接收执行结果。

4.5 监控Executor的状态

Master节点会定期从Worker节点上收集Executor的状态信息,例如运行时间、内存使用情况等。这些信息可以帮助Master节点监控和管理Executor的运行情况。

总之,Master节点在接收到Spark应用程序的注册请求后,会使用资源分配算法为应用程序分配资源,并在相应的Worker节点上启动Executor。通过与Driver节点建立连接,Executor可以接收任务并执行,并将结果返回给Driver节点。Master节点会监控Executor的状态,以确保应用程序能够顺利执行。

Worker节点启动Executor的过程

5.1 接收Master节点的指令

当Master节点决定在某个Worker节点上启动Executor时,它会向该节点发送启动Executor的指令。Worker节点收到指令后,会开始启动Executor进程。

5.2 启动Executor进程

Worker节点启动Executor进程时,会为其分配一定的资源。这些资源可以包括CPU核数、内存容量、磁盘空间等。一旦资源分配完毕,Worker节点会启动Executor进程,并将资源信息传递给Executor。

5.3 连接到Driver节点

Executor启动后,会与SparkContext中的Driver节点建立连接。这样,Driver节点就可以将任务分配给Executor执行,并通过网络传输数据和接收执行结果。

5.4 执行任务

Executor从Driver节点接收到任务后,会在独立的JVM中执行任务代码。每个Executor都运行在独立的JVM中,因此它们之间相互独立,互不干扰。

5.5 监控Executor的状态

Worker节点会定期从Executor进程中收集状态信息,例如运行时间、内存使用情况等。这些信息可以帮助Worker节点监控和管理Executor的运行情况。

总之,Worker节点为Spark应用程序启动Executor进程,并为其分配一定的资源。Executor通过与Driver节点建立连接,可以接收任务并执行,并将结果返回给Driver节点。Worker节点会监控Executor的状态,以确保应用程序能够顺利执行。由于每个Executor都运行在独立的JVM中,它们之间相互独立,互不干扰。

Executor反向注册到Driver的过程

6.1 Executor启动

Worker节点上的Executor进程启动后,会连接到Driver节点,并与其建立通信连接。

6.2 反向注册

Executor会通过通信连接向Driver节点发送注册请求。注册请求中包含了Executor的信息,例如Executor的标识、所在Worker节点的标识等。

6.3 TaskScheduler处理注册请求

Driver节点的TaskScheduler模块接收到Executor的注册请求后,会将Executor加入到可用Executor列表中。

6.4 任务调度

一旦Executor成功反向注册到Driver节点,TaskScheduler就知道有新的Executor可供任务调度。TaskScheduler根据调度策略和算法,将任务分配给可用的Executor执行。

6.5执行任务

Executor接收到由TaskScheduler分配的任务后,会在本地的Executor进程中执行任务代码。

通过Executor的反向注册,Driver节点可以知道当前有哪些Executor可供任务执行,从而更好地进行任务调度和资源管理。这种反向注册的机制使得Executor能够灵活地加入和退出Spark应用程序的执行环境,提高了任务执行的效率和可靠性。

触发DAG执行

Spark采用了延迟执行(Lazy Evaluation)的策略,即在用户调用Action操作之前,所有的转换操作(Transformation)都只会记录下来,并不会立即执行。这些转换操作构成了一个有向无环图(DAG),其中每个节点表示一个转换操作,边表示数据的流动关系。

当用户调用Action操作时,Spark会从Action操作的起点开始遍历整个DAG,并根据依赖关系逐步执行每个转换操作,将数据从一个节点传递到另一个节点,最终得到Action操作的结果。每个DAG对应一个job,即一个作业,作业是一组相关的任务(Task)的集合。

在DAG的构建过程中,Spark会进行优化和调整,以提高执行效率。例如,Spark会尽量将相邻的转换操作合并为一个更大的操作,在内存中进行数据复用,减少数据的序列化和反序列化开销等。这些优化措施可以提高Spark应用程序的性能和执行效率。

总结起来,用户调用Spark的Action操作时,会触发DAG的构建,每个DAG对应一个job。Spark会根据DAG中的转换操作和数据依赖关系,逐步执行转换操作并最终得到Action操作的结果。在DAG的构建过程中,Spark会进行优化和调整以提高执行效率。

DAGScheduler在划分Stage时会考虑以下几个因素

DAGScheduler的主要任务是根据转换操作之间的依赖关系将整个DAG划分为多个Stage,并确定Stage之间的执行顺序。Stage是Spark中并行执行的基本单位,每个Stage包含一组可以并行执行的任务。

DAGScheduler在划分Stage时会考虑以下几个因素:

窄依赖与宽依赖:

Spark中的转换操作可以分为窄依赖和宽依赖。窄依赖表示每个父节点只有一个子节点,可以在同一个分区内进行计算;而宽依赖表示每个父节点可能有多个子节点,需要进行数据的shuffle操作。DAGScheduler会将窄依赖的转换操作划分为一个Stage,而宽依赖的转换操作则会成为一个新的Stage。

数据本地性:

Spark尽量将任务调度到与数据位置最接近的Executor节点上,以提高运行效率。DAGScheduler会根据数据本地性将相关的任务划分到同一个Stage中。

任务数量与资源利用:

DAGScheduler会考虑任务数量和资源利用的平衡。较大的Stage可以提高并行度,但可能会导致资源不足;较小的Stage可以提高资源利用率,但可能会降低并行度。DAGScheduler会根据实际情况进行权衡和划分。

通过将DAG划分为多个Stage,Spark可以将任务并行执行,并充分利用集群资源。每个Stage内的任务可以在同一个Executor节点上并行执行,而Stage之间的任务则可以在不同的Executor节点上并行执行,以提高整个应用程序的执行效率。

总结起来,DAGScheduler负责将DAG划分为多个Stage,每个Stage包含一组相互依赖的任务。划分Stage时考虑了窄依赖与宽依赖、数据本地性以及任务数量与资源利用的平衡。通过并行执行Stage中的任务,Spark可以充分利用集群资源并提高应用程序的执行效率。

TaskScheduler支持多种任务分配算法

Spark中的TaskScheduler负责将每个Stage中的任务提交给可用的Executor进行执行,并根据具体算法进行任务的分配决策。

具体来说,TaskScheduler会将每个Stage中的任务(TaskSet)划分为多个Task,并根据任务的资源需求和当前集群的资源情况,将这些Task分配给可用的Executor进行执行。TaskScheduler会根据具体算法进行任务的分配决策,以确保任务可以在尽可能短的时间内完成,并充分利用集群的资源。

Spark中的TaskScheduler支持多种任务分配算法,包括:

**FIFO调度(First In, First Out):**按照任务提交的顺序进行任务调度,先提交的任务先执行。

**FAIR调度:**根据任务的优先级和已经运行任务的资源占用情况,将任务按照公平原则分配给可用的Executor。

**随机调度:**随机选择一个可用的Executor来执行任务。

**自定义调度:**用户可以自定义任务的分配算法,根据实际需求进行任务的分配决策。

通过合理的任务分配算法,TaskScheduler可以最大限度地利用集群资源,提高应用程序的执行效率。同时,TaskScheduler还可以根据任务的优先级来调整任务的执行顺序,以满足不同任务的需求。

总结起来,TaskScheduler负责将每个Stage中的任务提交给可用的Executor进行执行,并根据具体算法进行任务的分配决策。任务分配算法包括FIFO调度、FAIR调度、随机调度和自定义调度。通过合理的任务分配算法,TaskScheduler可以最大限度地利用集群资源,提高应用程序的执行效率。

Executor执行任务

具体来说,Executor内部有一个线程池,每当收到一个任务时,就会使用TaskRunner将任务封装成可执行的形式,并从线程池中取出一个线程来执行任务。

TaskRunner是Spark中的一个重要组件,它负责将Task(任务)转换为可执行的形式并运行在Executor上。TaskRunner会接收到DAGScheduler发送来的Task,将其转换为可供执行的形式,并提交给线程池中的一个空闲线程来执行。

TaskRunner的主要功能包括:

任务序列化:TaskRunner会将接收到的Task序列化为字节数组,以便在Executor之间进行传输。

任务反序列化:

TaskRunner会将接收到的字节数组反序列化为可执行的Task对象。

线程池管理:

TaskRunner会负责维护Executor内部的线程池,并从线程池中取出一个线程来执行任务。

运行任务:

TaskRunner会将可执行的Task对象交给线程池中的空闲线程来执行。执行完成后,TaskRunner会向DAGScheduler汇报任务的执行结果。

通过使用线程池来执行任务,Spark可以充分利用Executor的资源,并提高应用程序的执行效率。同时,线程池还可以帮助Spark控制任务的并发度,避免资源的浪费和竞争。

总结起来,Executor会使用线程池来执行任务。每当收到一个任务时,Executor会使用TaskRunner将任务封装成可执行的形式,并从线程池中取出一个线程来执行任务。TaskRunner负责任务的序列化、反序列化、线程池管理和任务执行等功能。通过使用线程池来执行任务,Spark可以最大限度地利用Executor的资源,并提高应用程序的执行效率。

任务执行过程中的关键步骤和资源管理

当TaskRunner在Executor上执行任务时,它需要将编写的代码、要执行的算子或函数进行拷贝和反序列化,以便在Executor上执行任务。具体步骤如下:

**代码拷贝:**TaskRunner会将任务需要执行的代码从Driver端拷贝到Executor所在的机器上。这样做是为了确保Executor具备执行任务所需的代码。

代码反序列化:TaskRunner会将拷贝到Executor上的代码进行反序列化,将其转换为可执行的形式。这一步骤是为了将代码还原成可以被Executor执行的形式。

**任务执行:**TaskRunner会根据任务的类型和参数,在Executor上执行任务。任务可以是数据转换、计算或其他操作,具体取决于用户编写的代码和算子。

执行结果反馈:任务运行完毕后,TaskRunner会将执行结果反馈给TaskScheduler。TaskScheduler负责收集和处理任务的执行结果,并将其反馈给DAGScheduler。

**结果写入数据存储:**如果任务的结果需要被存储,TaskRunner会将执行结果写入指定的数据存储(如HDFS、数据库等)。这样,任务的输出结果可以被后续的任务或其他应用程序使用。

**资源释放:**任务执行完毕后,TaskRunner会释放所有相关的资源,包括内存、文件句柄等,以确保资源的有效利用和回收。

通过以上步骤,TaskRunner在Executor上执行任务,并将执行结果反馈给TaskScheduler和DAGScheduler。同时,任务的输出结果会被写入数据存储,并释放所有相关资源。这样,Spark可以高效地执行任务并处理任务的执行结果。

通过对Spark底层执行原理的详细解析,我们可以更好地了解Spark的工作机制,从而更好地利用它进行大规模数据处理。同时,我们也可以更深入地理解分布式计算的原理和实现方式,这对于提高我们的数据处理能力以及解决实际问题具有重要意义。相信在不久的将来,Spark会在更多的领域得到广泛的应用,成为数据处理的重要工具。